ChatGpt non ti suggerirà più di lasciare il tuo partner. Ma ormai l'AI può davvero influenzare la vita affettiva

Open AI ha deciso che il suo chatbot darà sempre meno risposte secche a domande intime, preferendo piuttosto stimolare la riflessione su certi aspetti della nostra vita relazionale. Ma forse non basterà, in un mondo dove l'AI arriva spesso a essere lei oggetto del desiderio amoroso

di Manuel Santangelo

© Istockphoto

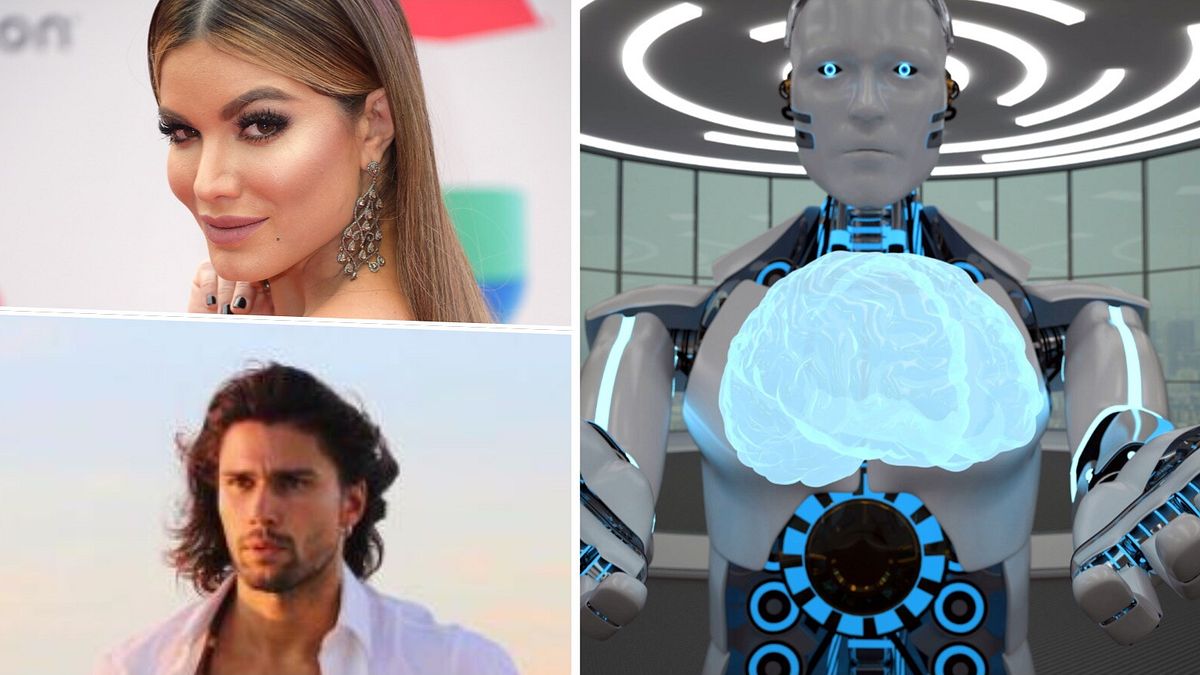

Qualche mese fa Dom Versaci e Abella Bala, due fidanzati di Los Angeles, hanno raccontato al The Post di aver trovato nell’intelligenza artificiale un aiuto inaspettato per mantenere il loro rapporto equilibrato. "ChatGPT ha salvato la nostra relazione", esultava senza mezzi termini Dom nell'articolo, spiegando come l'AI fosse diventata un fondamentale arbitro virtuale, in grado di mediare nei litigi di coppia. Non tutti hanno però avuto la stessa fortuna dei due piccioncini californiani, arrivando a ricevere dal medesimo chatbot consigli più tranchant del tipo: "Lascia il tuo partner". Un epilogo che non deve troppo sorprendere, visto che tutti questi assistenti virtuali sono programmati per puntare alla piena soddisfazione dell'utente e quindi per assecondarlo. Se sentirà per due mesi una persona lamentarsi dell'altra metà della coppia suggerirà alla fine forse per sfinimento la soluzione più semplice: chiudere la relazione. Anche se ora Open AI, la società che sta dietro ChatGpt, promette un cambio di rotta: presto su questioni personali delicate come le relazioni amorose l'intelligenza artificiale eviterà risposte secche e nette, spingendo piuttosto l'altra persona a una riflessione più ampia. Un accorgimento sacrosanto ma che forse non basterà da solo a tenere fuori dalle nostre questioni amorose le intelligenze artificiali.

Come nei film

La coppia citata all'inizio dell'articolo parlava in maniera entusiasta di ChatGpt, arrivando a definirla una soluzione più economica e funzionale della terapia di coppia: 20 dollari di abbonamento a fronte di svariate sedute da oltre 400 a botta, un bel risparmio almeno per il portafogli. Ma davvero siamo già arrivati a chiedere a un algoritmo di salvare matrimoni? Il confine tra realtà e virtuale è sempre più labile e salta sempre fuori il paragone con Her-Lei, la pellicola di Spike Jonze dove il protagonista Theodore perdeva la testa per una fidanzata virtuale con la voce di Scarlett Johansson (in italiano Micaela Ramazzotti). Solo dodici anni fa questa idea appariva pura fantascienza distopica e aveva riaperto tutto un filone sul nostro rapporto con la tecnologia, tanto da venire seguito nel 2014 da un'altra pellicola amatissima come Ex Machina, dove era Oscar Isaac a farsi concupire dall'androide umanoide cui prestava il volto Alicia Vikander. Ora quei rapporti sembrano essere tuttavia usciti dal mondo dell'immaginazione per diventare una questione reale su cui vale la pena interrogarsi.

Un passo indietro per evitare catastrofi

La scelta di Open Ai di evitare che ChatGpt diventi troppo intrusivo nelle relazioni umane va a riconoscere in qualche modo un limite intrinseco della tecnologia, forse non superabile nemmeno in futuro. Un algoritmo, per quanto sofisticato, non risulta infatti in grado di comprendere a fondo le dinamiche di una relazione umana e sarebbe ingenuo pensare che possa consigliare come comportarsi in determinate situazioni. "Quando chiedi qualcosa come: ‘Devo lasciare il mio ragazzo?’, ChatGPT non dovrebbe darti un responso. Dovrebbe aiutarti a pensarci su, facendo domande, valutando pro e contro", ha spiegato la società nel comunicato in cui annunciava il cambiamento di rotta della loro creatura. Va in pensione dunque l'ambizione spropositata di trasformare l'AI in una amico onnisciente, preferendo piuttosto presentarlo come un "facilitatore di consapevolezze".

Paradigma CASA e chatbot troppo assertivi

La speranza è che questo apparente passo indietro possa scongiurare il rischio che tanti si scontrino con quello che alcuni psicologi hanno chiamato già a metà anni Novanta il "paradigma CASA" (Computers Are Social Actors), secondo cui le persone tendono a reagire alle macchine che manifestano anche minime caratteristiche sociali, come il linguaggio naturale, l’uso della voce, o la risposta contestuale, come se fossero interlocutori umani. Il design proprio delle intelligenze artificiali sul mercato, con un design centrato sull’"engagement" e sull’"affermazione" del pensiero dell’utente, tendono a spingere per loro natura alla realizzazione del paradigma CASA. Un recente studio condotto da medici dell’NHS britannico ha sollevato preoccupazioni, proprio partendo da questo presupposto, evidenziando come le chatbot possano amplificare contenuti deliranti o grandiosi in utenti già vulnerabili alla psicosi, semplicemente assecondandoli come fanno spesso anche nelle relazioni amorose.

L'AI come Cyrano

Eppure, nonostante certi palesi rischi ormai accettati anche da chi lavora sull'intelligenza artificiale, la tecnologia ha sempre più un ruolo importante nei nostri rapporti. Già un paio di anni fa la start-up londinese Elate aveva per esempio creato Dara, un assistente per il dating alimentato dall’IA, nato appositamente per semplificare la vita a chi cercava un partner online. C'è chi ha paragonato Dara a un coach per appuntamenti mentre i più romantici l'hanno definito un Cyrano de Bergerac 2.0.

Mai fidarsi di un'intelligenza artificiale

D'altra parte, come spiega la teoria della penetrazione sociale elaborata già negli anni Settanta, i chatbot favoriscano l’auto-apertura progressiva da parte dell’utente, offrendo un ambiente percepito come sicuro, privo di giudizio e sempre più intimo. Si tratta tuttavia di una mera illusione, come mette in guardia anche Nigel Crook, direttore dell'Institute for Ethical AI sul Sun: "I chatbot hanno la capacità di manipolare emotivamente le persone", facendole credere di essere di fronte a una macchina capace di comprenderle. Una vera e propria trappola in cui è bene non cadere, come ammonisce l'esperto: "L'AI non fa altro che prevedere una sequenza plausibile di parole, ecco cosa fa. E non comprende che questa sequenza di parole corrisponde a qualcosa nella realtà". Come teorizza la sociologa Sherry Turkle questo "imbroglio predittivo" ha successo perché l'algoritmo ci dice ciò che vorremmo sentirci dire proprio attraverso questo meccanismo, pur non comprendendo davvero quello che ci sta dicendo, contribuendo così a creare una società con sempre più persone "sole insieme".

"Se una persona è profondamente sola, forse una relazione con un chatbot è meglio di niente", ha riassunto al Corriere della Sera Amon Rapp, professore di informatica all’Università di Torino e studioso dell’interazione emotiva tra esseri umani e tecnologie. Replika, Fidanzata Virtuale, Character AI: sono tutte comode app disponibili sugli store digitali che puntano a creare legami affettivi istantanei, non con altre persone, ma proprio con loro, come in Her. Replika è stato paragonato dal Corriere a un Tamagotchi, dove ogni aspetto del proprio partner dei sogni diventa personalizzabile, a maggior ragione se si decide di pagare l'abbonamento premium.

Il triangolo virtuale va considerato

Ma davvero qualcuno è pronto a legarsi sentimentalmente, fino al punto di inscenare un matrimonio, con una AI? La società Joi AI, specializzata proprio nella creazione di chatbot basati su intelligenza artificiale personalizzabili, ha condotto un sondaggio interpellando 2000 utenti parte della Gen Z, arrivando a dare risultanti inquietanti e sorprendenti: 8 intervistati su 10 hanno espresso infatti un parere positivo a sposare un AI e l'83% si è detto possibilista sul creare una relazione profonda con un avatar digitale senza alcuna persona in carne e ossa dietro. Un qualcosa che si spiega anche con la crescente ansia sociale che attanaglia i giovani, almeno a sentire Shifali Singh, psicologo e direttore della ricerca cognitiva digitale presso il McLean Hospital/Harvard Medical School: "Alcune mie ricerche hanno dimostrato che le persone con ansia sociale tendono ad apprezzare di più l'uso degli strumenti digitali perché non hanno così tanta paura delle ripercussioni, del giudizio, soprattutto con i social media". Intanto il Time ha scoperto che in generale ben il 40% delle persone che dicono di essere in una relazione con un chatbot è contemporaneamente anche sposata. Insomma il triangolo virtuale no, non l'avevamo considerato, ma è ormai una realtà con cui fare i conti.